自监督学习:AI 如何解决伦理、数据质量与偏见?

每一分钟,ChatGPT 被调用 6,944 次,DALL-E 生成 1,389 张图片,AI 生产 7,431 分钟的视频内容。人工智能(AI)正在爆炸式增长。而这一切都离不开自监督学习(Self-Supervised Learning, SSL)。本文将介绍自监督学习的工作原理、对 AI 性能的影响、伦理考量,以及企业如何利用 AI 提高效率。

什么是自监督学习?

在以往的文章中,我们探讨过监督学习和无监督学习。但 AI 发展迅猛,已经超越了这些传统的机器学习模式,进入了自监督学习时代。 简单来说,自监督学习结合了监督学习和无监督学习的优势:

- 监督学习:依赖人工标注数据进行训练。

- 无监督学习:自己从大量数据中寻找模式。

- 自监督学习:自己生成训练数据的标签,并以此进行学习。

自监督学习有哪些优势?

由于自监督学习能够自动生成标签,它可以利用比监督学习更多样、更大规模的数据进行训练,比如图像、文本、音频、视频等。这使得 AI 具备更强的可扩展性、稳定性和多功能性。

关键优势:

- 减少人工干预:不需要人工标注数据,训练更省时省力。

- 提高学习能力:比传统的无监督学习方法更容易理解复杂数据结构。

- 可与其他学习方法结合:可以配合监督学习进行微调,也可以与强化学习结合,以优化决策。

强大的 AI 模型正在推动 AI 的广泛应用,尤其是在生成和识别任务中。根据《福布斯》(Forbes Advisor)的报道,超过一半的企业已经在网络安全和欺诈管理中使用AI,而近一半(46%)的企业主将 AI 用于撰写内部沟通内容。

在 SEEBURGER,我们也充分利用 AI 技术,推出了 BIS Mapping Designer 的 AI 辅助功能,帮助不同水平的用户更高效、更精准地完成报文映射任务,并根据其当前技能水平提供相应的支持。

自监督学习的应用

自然语言处理:自监督学习的进展使得自然语言处理不仅提高了客服聊天机器人的真实性,还使 AI 聊天机器人能够在互动中发挥主导作用。例如,语言学习应用 Duolingo 最近推出了 AI 口语练习,可以与用户对话并提供个性化反馈。此外,其他 AI 教育产品能够根据特定学习者量身定制课程内容。

游戏行业:一群前 Google DeepMind 研究人员开发了一个 AI 行为引擎,旨在改善非玩家角色(NPC)在游戏中的表现和与玩家的互动。传统上,NPC 由决策树和预编写的脚本控制,这意味着大多数 NPC 与玩家的互动仅使用少量重复的对话内容,容易变得无聊且不真实。新的行为引擎要求开发者为 NPC 设定一组动机、规则和目标,这些将决定 NPC 如何回应玩家。该技术不仅可以整合到现有视频游戏中,还可以应用到全新的游戏中。

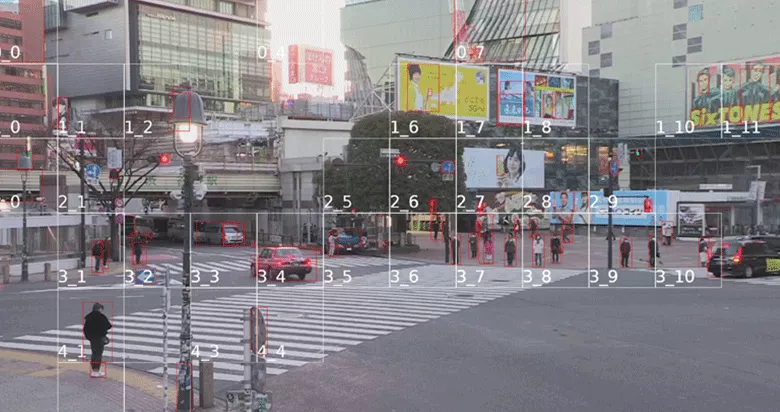

计算机视觉:自监督学习对计算机视觉,特别是图像识别任务,产生了巨大影响。最近有一个 AI 皮肤癌检测应用,其错误率为10%。错误率看起来很高,但医生的肉眼检查错误率高达20%。这项技术具有巨大的潜力,有助于医疗筛查,可以减轻健康系统的压力。

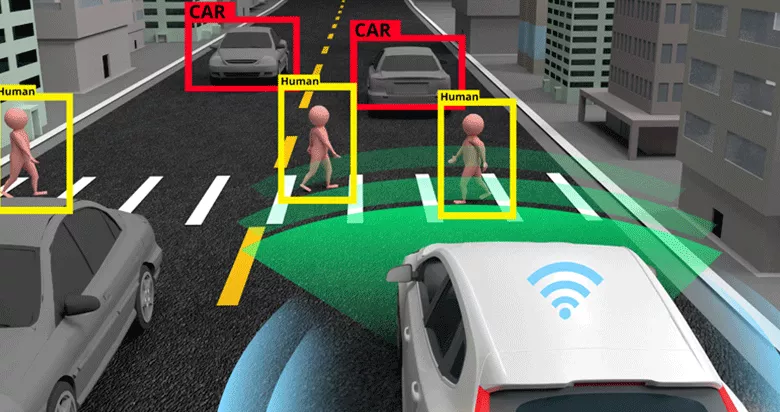

自动驾驶:自监督学习对自动驾驶系统的发展至关重要,能够改善传感器数据的处理。在传感器融合中,自监督学习方法整合来自不同传感器(例如摄像头、激光雷达、雷达)的数据,以创建对车辆周围环境的统一理解。这有助于提高物体检测和场景理解的准确性。传感器融合在工业物联网(IIoT)中也有应用。同时,自监督学习技术还用于基于历史数据预测物体和其他车辆的未来运动,称为轨迹预测,这有助于自动驾驶车辆做出更好、更安全的驾驶决策。

自监督学习如何自己生成训练标签?

核心概念:预训练任务(Pretext Tasks)

预训练任务是人为设计的训练任务,帮助 AI 自动提取数据中的重要特征。AI 会自己准备并完成这些任务,然后通过计算误差(损失函数)来调整自己。 通常,预训练任务是重建性的,涉及重建被修改过的数据。

重构式预训练任务

重构式性预训练任务(Reconstructive Pretext Tasks)指的是让模型通过填补缺失的信息来学习数据的结构和特征。这类任务常见于自然语言处理(NLP)和计算机视觉(CV)领域,包括以下几种:

预测下一个单词:在自然语言处理中,像 BERT 和 GPT 这样的模型会利用这一任务来学习如何在上下文中正确使用单词。例如,BERT 采用掩码语言模型(MLM),即随机遮盖句子中的某些单词,让模型预测这些缺失的单词。GPT-3 则使用自回归建模(Autoregressive Modeling),根据前面已知的单词预测下一个单词。

填补缺失的图像部分:在计算机视觉中,模型可以通过遮挡图像的部分区域,并训练其填补这些缺失区域,从而学习图像的空间关系和特征分布。

拼图任务:另一种常见任务是将一张图片分割成多个小块,并训练模型将这些碎片重新拼接回原来的位置。这样可以帮助模型学习物体的边界和空间布局。

在这些任务中,模型会完成前置任务并计算其预测的置信度。随后,预测结果会与真实数据进行比较,这一过程依赖于损失函数(Loss Function)。如果模型的错误预测置信度过高,它会受到更大的惩罚,从而促使模型朝正确的方向优化。

除了重构式预训练任务,自监督学习还使用对比式预训练任务(Contrastive Pretext Tasks)。

什么是对比学习?

对比学习(Contrastive Learning)是一种自监督学习方法,它的核心思想是让模型学会区分“相似”数据和“不相似”数据。训练过程中,模型会学习将相似的数据点映射到更接近的位置,而将不相似的数据点拉开距离,从而形成一种“心智地图(Mental Map)”,在该地图上,相似的数据点被聚集在一起,而不同的数据点被区分开来。对比学习主要用于各种识别任务,如图像分类、人脸识别等。

什么是对比式预训练任务?

对比式预训练任务(Contrastive Pretext Tasks)的核心在于“数据对”的概念。训练的目标是让模型将相似的数据对(正样本对)的表示靠近,而不相似的数据对(负样本对)的表示拉远。

在图像识别任务中,常见的方法包括对同一张图片进行不同的增强处理(例如旋转、裁剪、改变颜色等)来生成正样本对,并将它们与其他图片区分开来作为负样本对。模型需要学会识别这些经过变换的图像仍然属于同一个对象,同时能够区分不同的图像。

和重构式任务类似,模型的预测结果会经过损失函数计算误差,以优化其表现。

自监督学习模型如何完成任务?

要识别数据的特征、模式并据此做出决策,模型需要一个类似于大脑的计算结构——神经网络(Neural Network)。

神经网络是一种受人脑神经元启发的计算系统,由多个相互连接的节点(类似于神经元)组成。它通过不断传递和处理信息,学习数据中的特征模式,并最终做出预测。 针对不同的任务,使用的神经网络类型也不同。例如,在图像处理任务中,最常用的是卷积神经网络(CNN)。

卷积神经网络(CNN)是如何工作的?

尽管“卷积”这个词听起来很复杂,但卷积神经网络(Convolutional Neural Network, CNN)的原理其实非常直观。它通过多个滤波器(Filters)提取图像中的关键特征,并最终做出判断。整个过程由多个层组成。

| 输入层 | CNN 以图像作为输入。图像通常由像素网格表示。对于彩色图像,它包含红(Red)、绿(Green)、蓝(Blue)三个通道,每个通道都包含不同颜色的信息。 |

| 卷积层 | 输入的图像会经过多个滤波器(Filters)处理,这些滤波器是小型的数字矩阵,也称为卷积核(Kernels)。每个滤波器可以检测不同的特征,如边缘、纹理或特定模式。滤波器像滑动窗口一样在图像上滑动,并对每个区域进行卷积运算(Convolution),生成一个新的特征图(Feature Map),突出显示图像中的重要特征。 |

| 进一步处理层 | 这些层用于去除无关信息,压缩图像数据,减少计算量,同时保留关键特征,以便后续更容易处理。 |

| 全连接层 | 这些层会将前面提取的特征进行整合,并最终决定图像中是什么(如识别图像类别)。 |

| 损失函数检查 | 在自监督学习中,CNN 生成预测结果,并计算其置信度。然后,预测结果会与原始图像标签进行比较,使用损失函数(Loss Function)计算误差。例如,交叉熵损失函数(Cross-Entropy Loss)会对错误但高度自信的预测施加更大的惩罚,从而引导模型优化,提高准确性。 |

什么是机器学习中的变换器(Transformer )?

变换器是一种专门用于处理序列数据(如文本)的神经网络。它利用自注意力机制(Self-Attention),能够有效关注输入序列中的关键部分,从而理解并生成自然语言。Transformer由多个层组成,结构如下:

| 输入数据 | 文本输入后,会被转换为数字表示(即词向量)。 |

| 位置编码 | 本身不考虑单词的顺序,需要额外添加位置信息,让模型理解单词在句子中的先后关系。 |

| 自注意力机制 | 模型计算注意力权重,决定每个单词在语境中对其他单词的重要程度。例如,在句子“她把苹果吃了”中,“她”与“吃了”有很强的关联,而“苹果”也是关键信息点。自注意力机制帮助模型学习这些依赖关系。 |

| 多头注意力机制 | 为了让模型捕捉不同层次的单词关系,Transformer 采用多个自注意力头(Heads)并行处理,每个注意力头专注于不同的上下文关系。这样可以更全面地理解句子的语义。 |

| 前馈层 | 模型将经过注意力计算的特征进一步传递至全连接层,进行更深入的信息处理和特征提取。 |

| 堆叠层 | Transformer 由多个自注意力层+ 前馈层(称为 Transformer 块)堆叠而成。层数越多,模型能够学习到的抽象特征也越丰富。 |

| 输出层 | 根据输入信息,模型最终生成预测结果。例如,在分类任务中,最终层可能是 Softmax 层,用于预测文本的类别;在文本生成任务中,它可以是预测下一个单词的概率分布。 |

| 损失函数检查

| 在自监督学习中,Transformer 预测的结果会与真实标签进行对比,并计算误差(Loss)。损失函数不仅衡量预测是否准确,还会考虑模型的置信度,以优化其学习方向。 |

自监督学习中的问题

自监督学习(Self-Supervised Learning, SSL)的优势在于,训练模型时不需要依赖大量人工标注的数据集,避免了高昂的成本和繁重的标注工作。相比于监督学习,它可以利用更广泛的数据集,因为模型会自行创建预训练任务(Pretext Tasks)来学习。然而,模型的能力取决于所训练的数据。目前,大量用于训练自监督学习模型的数据是从互联网抓取的,这在数据质量和伦理道德上都引发了一系列问题。

数据偏差与知识产权问题

案例 1:Mumsnet 对 OpenAI 的诉讼

英国社交论坛 Mumsnet(拥有约160万女性用户)近日起诉 OpenAI,指控其未经许可抓取网站内容来训练其语言模型(LLM)。Mumsnet 官方声明提到了两个核心问题:

数据偏差(Data Bias)

“从某种角度来看,LLM 确实需要我们的对话数据。Mumsnet 上的60多亿字,记录了24年来女性在全球政治、时尚、家庭关系等方面的讨论。然而,网络上的大多数内容是由男性创作并面向男性的。许多 AI 模型带有固有的性别歧视(Misogyny),我们希望通过我们的数据来减少这些偏见,提高女性的声音。”

训练数据的价值(Data Compensation)

微软 AI 部门 CEO Mustafa Suleyman 认为,一旦内容发布到互联网上,就相当于“免费资源”。但 Mumsnet 反驳道:“允许 Google 索引 Mumsnet 的数据,我们可以通过搜索引擎流量受益,这是一种公平的价值交换。但 LLM 不同,它们使用抓取的数据构建出像 ChatGPT 这样的 AI,直接提供所有问题的答案,用户不再需要访问原网站。”

案例 2:YouTube 视频字幕数据被大规模抓取

近期,一家非营利 AI 研究实验室收集了173,536 条 YouTube 视频字幕,涉及48,000多个频道。尽管这些数据不包含视频画面,字幕文本也被公开提供以推动 AI 训练,但内容创作者既不知情,也未获得任何补偿。

案例 3:学术出版商与 AI 企业的交易

学术出版商 Taylor & Francis 近期与微软达成协议,允许微软访问其大量学术出版物。然而,作者们既未被告知,也未获得报酬,这引发了关于数据归属权和商业利用的伦理争议。

案例 4:计算机视觉中的数据偏见

麻省理工学院(MIT)研究员 Joy Buolamwini 和 Timnit Gebru 在2018年的一篇论文中指出,人脸识别软件在识别深色皮肤女性时误差率高达34.7%,而白人男性的误差率仅为0.8%。原因在于,模型的训练数据主要来自白人男性,导致模型在实际应用中对其他群体的表现较差。

案例 5:AI 招聘中的性别歧视

历史薪资数据显示,女性的工资往往低于男性,即使是同样的工作。如果一个自监督学习的 AI 招聘系统学习到这一规律,它很可能会自动向女性候选人提供更低的薪资,加剧性别不平等。

数据质量问题

有时,高质量的数据集并不存在,必须人为创建。例如,AI 仍然难以处理雨滴影响的图像。

雨滴清晰度项目(Raindrop Clarity Project)为了让 AI 识别和去除雨滴带来的视觉干扰,研究人员拍摄了15,186 张照片,其中包含三种图像:清晰图像(无雨滴);雨滴遮挡图像(在透明玻璃上喷洒水滴并用相机拍摄);聚焦于雨滴的图像。

此外,他们还采集了夜间图像,以提升 AI 处理复杂光照条件下的能力。这些高质量数据集正在帮助 AI 更准确地去除雨滴干扰,提升计算机视觉的稳定性。

如何在企业中应用 AI?

Colin Murdoch(DeepMind 首席商务官)表示:“企业首先要搞清楚:我的数据在哪里?我如何整理这些数据,以便 AI 进行预测!”

企业在应用 AI 时,通常会面临以下几种情况:

- 整理并收集自身数据(如财务管理系统中的数据)

- 训练自有 AI 模型

- 在云端 AI 平台上训练数据

- 集成 AI 提供商的云端 AI 解决方案

无论采取哪种方式,数据管理都是核心挑战之一。

SEEBURGER 如何提供帮助?

1. 数据集成与传输

SEEBURGER BIS 平台是一款集成平台(Integration Platform),可实现:

- 安全传输:BIS 平台的可控大文件传输(MFT),可实时将大量机密数据传输至数据湖或其他端点,包括 API 连接。

- 应用集成:BIS平台的 EAI/A2A(企业应用集成)功能,可快速连接多个应用系统,实现企业内部数据流转。

- API 管理:当企业通过 API 访问 AI 服务或传输数据时,BIS 平台提供强大的 API 管理能力,确保性能监控、安全性和访问控制。

2. 快速接入 AI 云服务

如今,许多 AI 服务已作为 SaaS(软件即服务)提供。BIS 平台的 EAI/A2A 连接器可帮助企业快速接入这些云服务,并支持不断更新的安全映射配置,确保兼容性。

3. 支持主流云平台

目前,三大云计算巨头(Hyperscalers)AWS、Microsoft Azure 和 Google Cloud 均提供 AI 训练和推理服务。

BIS 平台可作为 iPaaS(集成平台即服务),部署在公有云、私有云或本地环境,避免数据流出云端产生的额外费用和延迟。

4. 其他集成功能

BIS 平台可作为全托管服务(SaaS),或在企业私有云、公有云或本地服务器上运行,满足不同企业的需求。